Organization

1. Erwartungswert

2. Funktionen der ZV

3. Varinaz

4. Kovarianz

5. Unkorrliertheit

6. Korrelationskoeffizient

8. Erwartungswert

8.1 Erwartungswert

gibt den mittleren Wert einer Zufallsvariablen an : 간단히 말해 확률변수들의 평균을 말한다.

$$ E[X] = \sum_{x \in \Omega'} \ x \cdot \mathbf{P}_X (x) \cong \int_{\mathbb{R}} \ x \cdot f_X(x) dx $$

diskrete \( X: \Omega \rightarrow \Omega'\) stetige \( X: \Omega \rightarrow \mathbb{R}\)

Eigenschaften:

- Linearität : \( \qquad E[\alpha X + \beta Y] = \alpha E[X] + \beta E[Y] \)

- Monotonie: \( \qquad X \leq Y \Rightarrow E[X] \leq E[Y] \)

- sonstiges: \( \qquad E[\alpha] = \alpha , \alpha \in \mathbb{R}, \quad E[X - E[X]] = 0 \)

- Umkehrung nicht möglich: \( E [X Y] = E[X] E[Y]\), fallx X ud Y stochastisch unabhängig /그러나 기댓값의 곱이 각 변수의 곱과 같지 않아도 확률의 독립 유무는 알 수 없다.(반대는 성립하지 않는다.)

- Integral: \( \qquad E[X Y] = \int_{\mathbb{R}} \int_{\mathbb{R}} xy \cdot f_{X, Y} (x, y) dx dy \)

Spezialfall für \( X : \Omega \rightarrow \mathbb{R}_+ : \)

$$\mbox{stetig} : E[X] = \int^{\infty}_0 \ \mathbf{P}(X > t) dt $$

$$\mbox{diskret} : E[X] = \sum^{\infty}_{k=0} \ \mathbf{P}(X > k)$$

8.1.1. Für Funktionen von Zufallsvariablen \( g : \mathbb{R} \rightarrow \mathbb{R} )\

$$ E[g(X)] = \sum_{x \in \Omega'} \ g(x)P_X(x) \cong \int_{\mathbb{R}} g(x)f_X(x) dx $$

Beiepiele für Erwartungswerte von Funktionen von Zufallsvariablen

- \( n \) -tes Momment der Zufallsvariablen X: \( \qquad E[X^n] = \int^{\infty}_{- \infty} X^n f_X(x) dx \)

- Y stetig & \( g(Y) = cos^2(\cfrac{\pi}{2} Y) \) : \(\qquad E[cos^2(\cfrac{\pi}{2} Y)] = \int^{\infty}_{- \infty} cos^2(\cfrac{\pi}{2} y) \cdot f_Y(y) dy \)

- \( N\) diskret & \( g(k) = 2^{L \cdot k}\) : \( \qquad E[2^{L \cdot N}] = \sum_{k \in \Omega'} \ 2^{L \cdot k} \ \cdot \ p_N(k) \)

9. Varianz und Kovarianz : 분산과 공분산

9.1 Varianz

Def ) Varianz ist ein Maß für die Stärke der Abweichung von Erwaratungswert

$$ Var[X] = E[(X - E[X])^2] = E[X^2] = E[X^2] - E[X]^2 $$

Eigenschaften:

- \( Var[\alpha X + \beta] = \alpha^2 Var[X] \)

- \( Var[X] = Cov[X, X] \)

- \( Var \begin{bmatrix} \sum^n_{i=1} X_i \end{bmatrix} = \sum^n_{i=1} Var[X_i] + \sum_{j \neq i} Cov[X_i, X_j ] \)

$$ \rightarrow n = 2 : Var[X + Y] = Var[X] + Var[Y] + 2 ]cdot Cov[X, Y] $$

- \( Var[const.] = 0\)

- \( \mbox{falls} \ E[X] = 0 : Var[X] = E[X^2] \)

9.1.1 Standard Abweichung : 표준편차

$$ \sigma = \sqrt{Var[X]} $$

9.2 Kovarianz : 공분산

Maß für den linearen Zusammenhang zweier Variablen

$$ Cov[X, Y] = E[(X - E[X])(Y - E[Y])] = Cov[Y, X] $$

$$ Cov[X, Y] = E[X\ Y] - E[X] E[Y] = Cov[Y, X] $$

Eigenschaften:

- \( Cov[\alpha X + \beta, \gamma Y + \delta] = \alpha \gamma Cov[X, Y] \)

- \( Cov[X + U, Y + V] = Cov[X, Y] + Cov[X, V] + Cov[U, Y] + Cov[U, V] \)

9.3 Unkorreliertheit

wenn gilt:

$$ Cov[X, Y] = 0 \iff E[X \ Y] = E[X]E[Y] $$

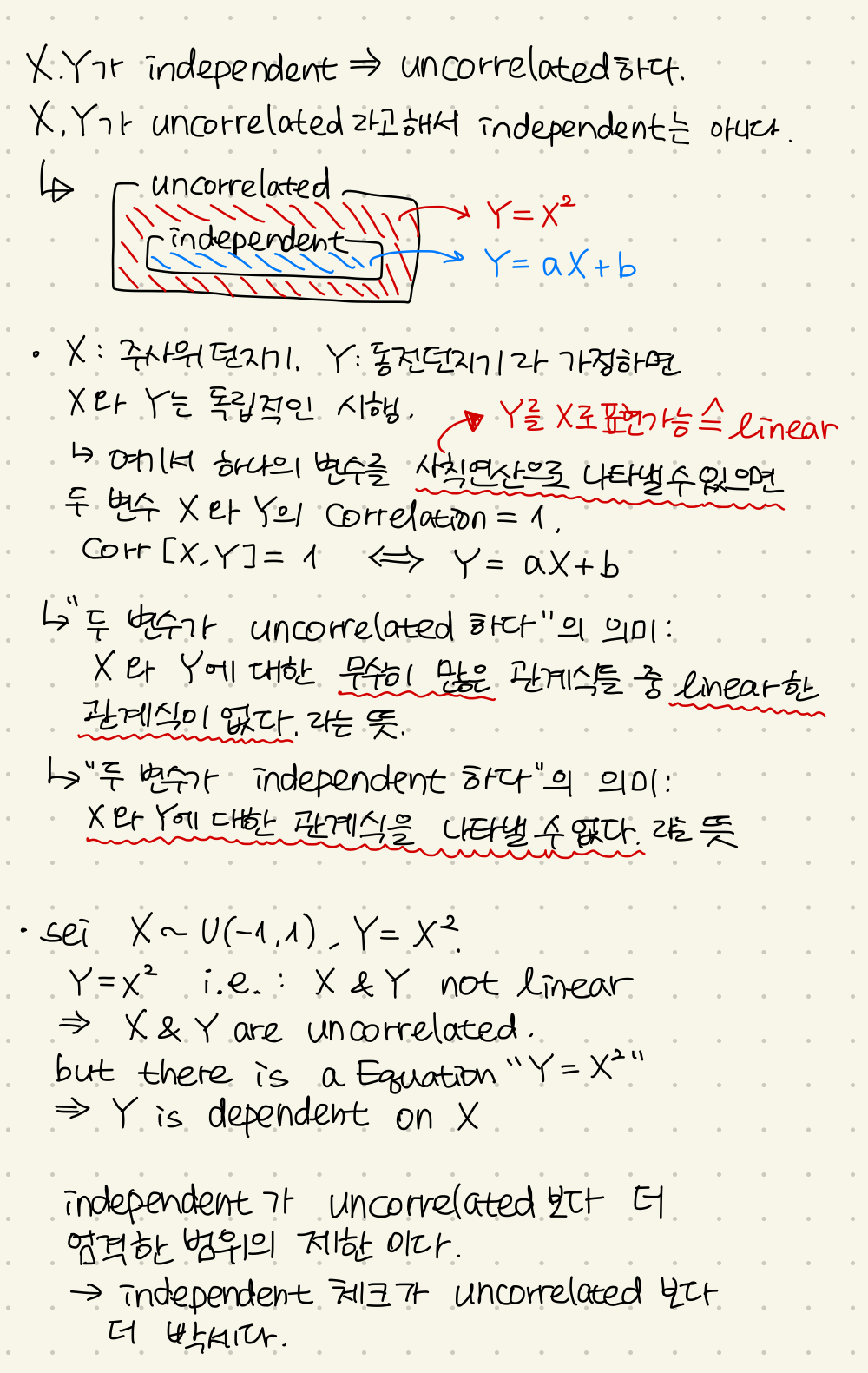

stochastische unabhängig \( \Rightarrow \) Unkorreliertheit

두 확률변수가 independent하면 uncorrelated하다. 그리고 역은 성립하지 않는다. 그러나 두 확률변수가 정규분포일때,는 uncorrelated하면 independent하다.

bei parrweisen unkorrellierten Zufallsvariablen:

$$ Var \begin{bmatrix} \sum^n_{i = 1} X_i \end{bmatrix} = \sum^n_{i = 1} Var[X_i] $$

X, Y unkorreliiert \( \Rightarrow \) es besteht kein linearer Zusammenhang zw. X und Y

9.4 Orthogonalität

$$ E[X Y] = 0 $$

mit dem Korrelationswert E[X Y]

9.5 Korrelationskoeffizient

$$ \rho_{X, Y} = \cfrac{Cov[X, Y]}{\sqrt{Var[X]} \sqrt{Var[Y]}} = \cfrac{c_{X, Y}}{\sigma_X \sigma_Y} \mbox{mit} \rho_{X, Y} \in [-1, 1] $$

Korrelationskoeffizient von X und Y

Es gilt : \( \begin{cases} \mbox{negativ korreliert} \quad & \rho_{X, Y} \in [ -1, 0) \\ \mbox{unkorreliert} \quad & \rho_{X, Y} = 0 \\ \mbox{positiv korreliert} \quad & \rho_{X, Y} \in (0, 1] \end{cases} \)

댓글